生成AIを使う上で、「生成AIは誤った情報を出力してしまうことがある」ということを気を付けなければいけません。特に生成AIは「誤った情報をさも正しいかのように出力してしまう」という悪い特徴があり、この特徴は「ハルシネーション(幻覚)」と呼ばれています。例えば、

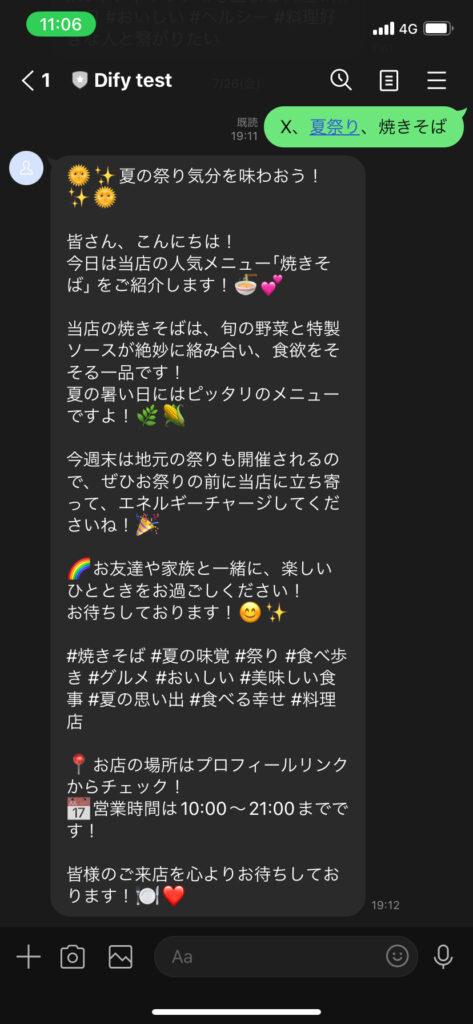

こちらはLINEとChatGPTを連携させて、お店のSNS広告文を生成するサービス(試作品)です。

キーワードに対応してSNSらしい文章を生成していることが分かるのですが、後半の

「お店の場所はプロフィールリンクからチェック!営業時間は10:00~21:00までです!」

という文章は特に指定していないにもかかわらず出力されてしまっており、そのお店の営業時間と

合っているかどうかは全く考慮されていません。

この例では対象のお店の営業時間を調べればすぐに分かるので良いのですが、場合によっては

本当に正しいかどうかよく調べないと、生成AIに騙されてしまう可能性があります。

そこで、「①ハルシネーションかどうか見極める」「②ハルシネーションさせない」

という二つの対策で対策していこうと思います。

①ハルシネーションかどうか見極める

ハルシネーションかどうか見極めるにはやはりファクトチェックが重要です。

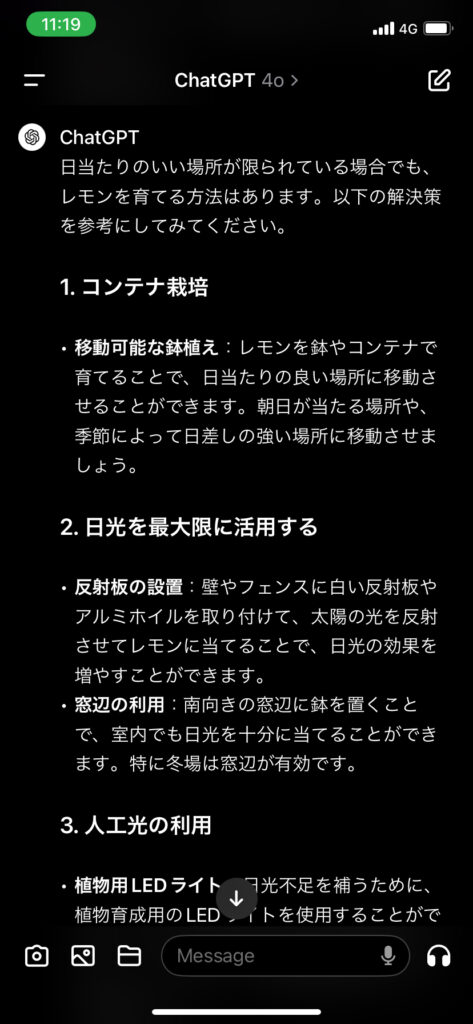

これは、日当たりの悪い場所でのレモンの育て方をChatGPTに聞いた例です。これをファクトチェックするには、

例えば「人口光を利用してレモンを栽培した例を検索して」※注というように「検索して」や「調べて」を含めて質問することで、「browse with bing」機能を使って実例検索することができます。

※注 有料版(ChatGPT pro)に加入していない場合、この機能は使うことができません。

②ハルシネーションさせない

ハルシネーションを完全に防止するのは残念ながら難しいです。ただし、

・ハルシネーションを抑制する(できる限り正確な情報のみを生成させる)

・最初の例のように「特定の項目(例えば営業時間)」に限って、勝手に生成させないようにする

ことは、プロンプトで出力ルールを定めることによって可能です。

・ハルシネーションを抑制する

例えば、レモンを育てる例では下記のように書きます。

「日当たりの悪い場所でのレモンの育て方を教えて。

回答は以下の<ルール>を守ること。

<ルール>

・正確で確実な情報のみを回答すること。不正確な情報を提供しないこと。

・回答が正確かどうか分からない場合は「わかりません。」のみ回答すること。」

</ルール>

生成AIの特徴として、解答が「分からない」場合でも何とかして回答しようとしてしまうという特徴があります。

これを防止するために「分かりません。」と回答するルールを作っておくことで、不正確な情報が出力されるのを

ある程度防ぐことができます。

・「特定の項目(例えば営業時間)」に限って、勝手に生成させないようにする

こちらも目的のプロンプトの下に、

「回答は以下の<ルール>を守ること。

<ルール>

・営業時間を生成しない。

</ルール>」

というように記入することで、営業時間が記載されてしまうのをある程度防げます。

これでも生成されてしまうような場合は出力ルールをさらに細分化するなど何回か調整が必要な場合もあります。

ここまでお読みいただきありがとうございました。